|

|

楼主 |

发表于 2025-2-20 11:39:13

|

显示全部楼层

DeepSeek发布最新技术论文:训练速度提升9倍,推理速度快11倍!梁文锋参与署名

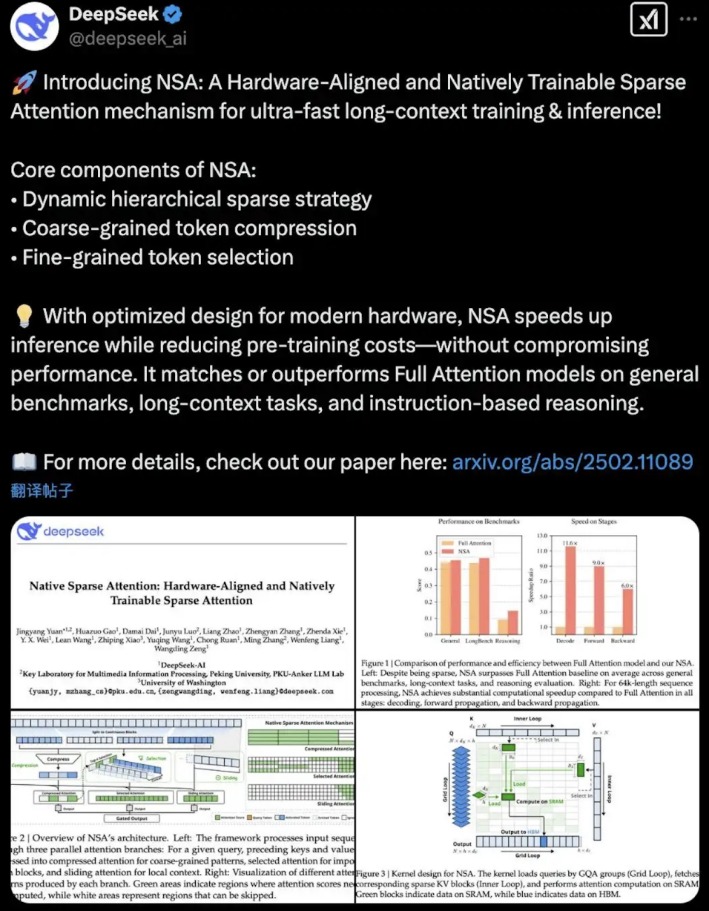

就在Grok3发布的当天,DeepSeek团队发表了一篇论文,介绍了一种新的稀疏注意力机制(Natively Sparse Attention,NSA),用于提升长文本训练和推理的效率,并具备硬件对齐和端到端训练的特性。2月18日,DeepSeek在海外社交平台发布了一篇纯技术论文报告,论文主要内容是关于NSA(Natively Sparse Attention,原生稀疏注意力)。据介绍,这是一种用于超快速长文本训练与推理的、硬件对齐且可原生训练的稀疏注意力机制。

为了打造最强AI大模型,xAI投入了20万块H100 GPU,计算资源是上一代Grok2的15倍左右。在Benchmarks中,Grok3毫无悬念成功地领先Deepseek R1、o3 mini等对手。不过用如此大规模的算力集群,花费上一代15倍的计算资源投入,业界认为Grok3的性能只是略微提升了大模型能力上限,实际提升幅度低于算力投入的预期。这或许也预示着大模型的Scaling Laws或许已经出现边际效益递减。

截至19日下午,这篇推文在X上已经有超过180万观看量。值得一提的是,DeepSeek创始人梁文锋也出现在这篇论文的作者名单中。下面我们就来看一下这篇论文有哪些创新点。在大语言模型(LLM)发展的初期,曾经有一段时间处理长文本是考量不同模型性能的指标之一。因为传统LLM在处理长文本时要面临的一个问题是,计算成本过高。

根据论文摘要,DeepSeek团队表示,业界越来越认识到长上下文建模对于下一代大型语言模型的重要性。然而,随着序列长度的增加,标准注意力机制的高复杂度成为了关键的延迟瓶颈。据悉,NSA通过高效的长序列处理能力,使模型能够直接处理整本书籍、代码仓库或多轮对话(如千轮客服场景),扩展了大语言模型在文档分析、代码生成、复杂推理等领域的应用边界。

NSA通过针对现代硬件的优化设计,在提高推理速度的同时、降低预训练成本,而不会牺牲性能。它在通用基准测试、长文本任务和基于指令的推理中均能达到或超越全注意力模型的表现。稀疏注意力为提高效率同时保持模型能力提供了一个有前景的方。DeepSeek在使用NSA进行验证时,实际效果也相当喜人。首先是模型的训练和推理速度都有明显的提升,在64k长度的文本处理中,使用英伟达A100 GPU,NSA的推理速度比传统注意力快11.6倍,训练速度提升6-9倍。

同时在知识问答(MMLU)、代码生成(HumanEval)、长文本理解(LongBench)等任务中,NSA的性能与全注意力模型相当甚至更好。证明NSA在提高效率的同时,依然可以保持良好的模型性能。通过适配GPU的Tensor Core和内存架构,NSA也能最大化硬件利用率。NSA首次将分层稀疏策略与GPU内存层级(HBM→SRAM)对齐,实现理论计算节省与实际加速的统一。

所以总结下来,NSA的出现解决了稀疏注意力机制在实际应用中的两大难题。在推理效率上,NSA显著加快长文本处理速度,令大模型能够处理更多超长文本任务;在训练上,NSA相比传统的稀疏注意力机制,可以更好地支持模型训练。更重要的是,NSA证明了稀疏注意力不是只能被用于推理,还能在训练上应用,这能够为下一代低功耗、高吞吐的LLM部署提供了关键技术基础。

|

|